眼控技术能通过智能手机或者平板电脑的前置摄像头获取图像,利用计算机视觉算法进行分析。软件能定位眼睛的位置,估计你正在看屏幕的什么地方,甚至精确到非常小的图标。这项眼控技术能够取代手指,控制平板电脑或手机。眼动控制会成为智能手机、平板等手持设备交互界面的下一波潮流。

微软的游戏操控设备 Kinect 有一句广告语:You are the controller(你就是遥控器)。通过 Kinect,普通人不需要使用任何手柄、摇杆、鼠标或者其他遥控器就能操控游戏,这让 Kinect 远远超越了普通家用游戏机的段位。事实是,人们也没有把它仅仅当成游戏机,无数黑客对其进行破解,开发出一系列创新发明,有模拟光剑道具,也有自动跟着垃圾跑的垃圾桶,甚至英国一所大学正在基于它研发一种技术帮助中风患者恢复健康。

新的人机交互方式让计算机能读懂人所传递的命令。现在,眼睛是人们开发的下一个目标去年底,丹麦公司 Senseye 发布了一个视频。

视频里,一个人捧着平板电脑在玩“切水果”的游戏——不过,他没有动一根手指,而是完全用眼神控制。后来,这家由四个丹麦博士生创立的公司改名为“The Eye Tribe”,他们开发的眼控技术能通过智能手机或者平板电脑的前置摄像头获取图像,利用计算机视觉算法进行分析。软件能定位眼睛的位置,估计你正在看屏幕的什么地方,甚至精确到非常小的图标。这项眼控技术能够取代手指,控制平板电脑或手机。据国外媒体报道,他们已经开始与手机制造商和运营商进行合作,希望明年能将正式产品推向市场。

除了用眼神控制手机,用眼睛操控的概念笔记本、眼控相机等产品也已面世。以眼神的移动轨迹为基础进行的人机交互方式,是继 Kinect 之后人机交互界面的又一次革命。

眼睛上的实验

17 世纪初,人们就开始研究眼睛的运动。1879 年,法国人路易斯·艾米·贾维尔观察到,人们的眼睛在阅读文字时,并非像之前猜想的是平滑地一行行扫射,而是每隔几个字就会有短暂的视觉停留。

于是人们很好奇:阅读时,眼睛会停留在哪些字上?停留多长时间?

为了研究这个问题,埃德蒙·休伊做出世界上第一个眼睛追踪器:一个有洞的隐形眼镜,和一个会根据眼睛活动摆动指针的铝制指示器相连。但这个追踪器因为要和眼球接触,对眼睛的干扰比较大。另一个芝加哥的家伙托马斯·巴斯维尔转换了思路,做出了一个非接触式的追踪器,他利用光束照射眼睛,通过在电影胶片上记录眼睛反射的光记录眼睛的活动轨迹。他用这个装置研究人们阅读和观看图片的行为习惯。

到了 1980 年,眼睛追踪器被用来研究和人机交互有关的问题;比如,研究人员很好奇用户如何在电脑菜单中搜索命令。最近几年,人们越来越多运用眼部追踪器研究用户如何和不同的计算机界面互动,结果往往能改变界面的设计。其他的研究包括用户如何对待下拉菜单,他们通常将注意力集中在网站的什么位置,开发人员就会知道该在哪里设计广告位。

随着眼控技术的发展,和人类对视觉生理及心理的了解,基于人类视觉系统(Human Vision System, 简称“HVS”)的凝视绘制技术也逐渐成为图形学的研究热点。这种技术通过略去不为用户感知的画面区域的图像细节来提高图像的绘制和显示效率。

在研究中,人们普遍达成的共识是,“注意力”和眼睛看在哪并不统一,前者总是比眼睛要领先大约 100-250 微秒;也就是说,人的注意力转移到新的位置 100-250 微秒后,眼睛才会跟随其后。

在技术上,眼控技术已经相当成熟,在工业控制、机器人学和临床医学领域都有应用,只是还没有应用到消费领域。它是基于角膜反射原理,通过光在用户眼睛角膜上形成高亮度反射点作为参考点,当眼球转动注视屏幕上不同位置时,由于眼球近似为球体,光斑不动,瞳孔相对光斑发生偏移,利用瞳孔中心和光斑的位置关系就能确定视线方向。目前运用最广泛的设计是以视频为基础的眼睛追踪器。一个设想镜头聚焦在一只或一双眼睛上,在观众受到某种刺激时记录它们的变动。眼控技术的核心是算法,如何让系统迅速准确地“学习”人眼睛的各种行为,这是个挑战。

EyePhone

EyePhone 应该翻译成“眼机”或者“目机”?似乎都不太好听。在大触屏手机广泛流行之前,有人就开始研究如何用眼睛控制手机了。

美国达特茅斯学院(Dartmouth College)就有一支眼控手机的研发团队,他们试图创造一套眼睛追踪系统,开发以眼睛来控制手机的操作方法。

让眼睛追踪系统运用到操作系统里,重要的是设计一套能够实现的软件。首先,你需要校准这个系统,在室内室外不同光线下盯着同一张图片看,让软件学习、识别你的眼睛在不同光照条件下的运动。他们在诺基亚 N810 上做了试验,设计出一个初始“眼菜单”,屏幕被分为9格,分别对应邮件、接电话、拍照片、日历、短信等不同功能。当一个人盯着某一块区域看时,某一个功能区域就被激活高亮显示,一眨眼,这个功能就被激活。

根据《麻省理工科技评论》杂志 2010 年的报道,眼控式手机的技术研发已经数年。进行这项技术开发的主要目的,是希望能让手部残疾的人克服无法使用电话的障碍。

在这项研究中,整个系统技术含量最高的部分就是自动校正系统,它需要算法优化,提高光学采集精度,实现视线跟踪,适应外部环境光强度变化,判别眼睛睁、闭状态等。带领“EyePhone”研发团队的安德鲁·坎贝尔(Andrew Campbel)教授认为,眼控式手机解放了双手,不仅仅是残疾人,每个人都能享受到它带来的极大便利。但靠眼神操作手机,比在桌上的电脑执行眼控指令更困难,因为使用者和手机都是行动中的物体,而周围环境也是变幻莫测,如何演算和辨识使用者在不同的状态下所传达的眼神收发讯号,是最难解决的问题。

在 2011 年的 Cebit 展上,联想和瑞典眼控技术公司 Tobbi 联合发布了一款概念笔记本,特制的长方形感应器能够追逐眼球的移动轨迹,记录数据,电脑处理器把这些数据转化为鼠标控制,整个系统并不会让眼控的过程感觉十分刻意,也不会像传统的眼控系统一样过于敏感或是过于驽钝。

Tobii 公司成立于 2001 年,是一家专门研发眼动追踪和眼动控制技术的公司。除了桌面眼动电脑,他们也在研发一款具备眼控界面的 windows 平板电脑 C12,用户可以转动眼珠来移动 C12 上的鼠标指针,而眨眼则代表点击。机器里设置了一个校准界面,允许多个用户定义眼控指令。

最近,一位英国皇家艺术学院的毕业生设计了一款用眼睛控制拍摄的概念相机 Iris,整个相机就像一支镜头,你从镜头中取景,用眼睛对焦,张开/眯起眼睛完成变焦,最后眨眼完成拍摄。

而本文开头提到的那个丹麦公司“The Eye Tribe”已经融到了一笔 80 万美元的资金,用于他们的商业拓展。他们专门研究用于平板和手机系统的眼控技术,开发了相应的算法和软件,团队中还有一位博士专门研究低成本眼控技术。“眼动控制会成为智能手机、平板等手持设备交互界面的下一波潮流,谷歌眼镜也很可能会用到这个技术。”公司的联合创始人兼 CEO 苏恩·约翰逊(Sune A Johnson)对媒体说,他们希望能站在潮流的顶端。

全球未来10大最酷洗衣机

全球未来10大最酷洗衣机  据说这46招能让你变得更聪明

据说这46招能让你变得更聪明 逆天了!这些发明居然是出自科幻小说

逆天了!这些发明居然是出自科幻小说 我们未曾在意的10项重要技术

我们未曾在意的10项重要技术  中国文化中的神仙都是怎么诞生的

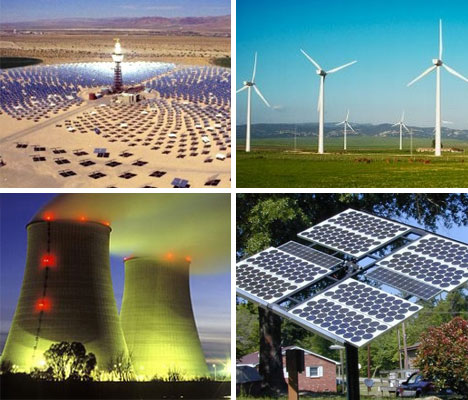

中国文化中的神仙都是怎么诞生的 盘点全球八个最好和最差的电能来源

盘点全球八个最好和最差的电能来源 拯救地球10大新技术 沼气池也光荣入选

拯救地球10大新技术 沼气池也光荣入选 全球访问量最NB的17个网站,有你常去的吗?

全球访问量最NB的17个网站,有你常去的吗?